| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 | 29 |

| 30 |

- 클래스

- 제어문

- NLP

- 제로베이스 데이터사이언스

- 자연어처리

- 데이터분석

- Set

- 아이펠

- 카카오

- 스크랩

- 속성

- 기사

- AIFFEL

- 추천시스템

- numpy

- Python

- 데이터사이언티스트

- 딥러닝

- 파이썬

- 코딩도장

- 파이썬코딩도장

- 데이터사이언스 스쿨

- 사이킷런

- TensorFlow

- 머신러닝

- 재귀함수

- 후기

- 함수

- 딕셔너리

- AI

- Today

- Total

뮤트 개발일지

AIFFEL 아이펠 32일차 본문

활성화 함수의 이해

신경망 속의 퍼셉트론(perceptron) 혹은 노드(node)는 특정 조건이 만족되면 활성화되도록 디자인되어 있다. 노드에 입력으로 들어오는 값이 어떤 임계치를 넘어가면 활성화되고, 넘어가지 않으면 비활성화되는 것이다.

예) ReLU는 입력값이 음수라면, 0을 출력하고 0이상이면, 입력값 그대로를 출력하도록 디자인되어 있다.

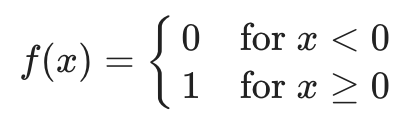

이진 계단 함수 Binary step function

입력이 특정 임계점을 넘으면 1을, 그렇지 않을 때는 0을 출력한다.

한계)

역전파 알고리즘을 사용하지 못한다. 이진 계단 함수는 0에서는 미분이 안 될뿐더러 0인 부분을 제외하고 미분을 해도 미분 값이 모두 0이 나온다. 따라서 역전파에서 가중치들이 업데이트되지 않는다. 현실의 대부분 문제들은 다층 인공신경망을 사용하고, 이런 인공 신경망을 훈련시킬 때 역전파 알고리즘을 사용한다. 즉, 현실의 복잡한 문제는 사실상 해결하기 어렵다.

또한 다중 출력을 할 수 없어 다양한 클래스를 구분해야하는 문제는 해결할 수 없다.

선형 활성화 함수 Linear activation function

이진 계단 함수를 사용한 모델과 다르게 다중 출력이 가능하다. 때문에 다중 분류 문제도 해결할 수 있고, 또한 미분이 가능해서 역전파 알고리즘도 사용할 수 있다. 그러나 비선형적 특성을 가진 데이터는 예측하지 못한다.

비선형 활성화 함수

시그모이드 함수 Sigmoid function

시그모이드 함수의 치역은 (0,1), 즉 0 < σ(x) < 1이다. 확률을 예측해야하는 모델에서 자주 사용된다.

단점)

시그모이드 함수는 0 또는 1에서 포화saturate된다. 즉, 입력값이 아무리 커져도 함수의 출력은 1에 가까워질 뿐 1이상으로 높아지지 않고, 입력값이 아무리 작아져도 0에 가까워질 뿐 0이하로 떨어지지는 않는다. 이렇게 포화되면 발생하는 일은 그래디언트가 0에 아주 가까워지는 것이다. 역전파에서 0과 가까워진 그래디언트는 앞에서 온 역전파 값에 곱해지는데 그러면 그 이후에 전파되는 모든 역전파 값이 0에 근접하여 사실상 가중치 업데이트가 일어나지 않게 된다.(kill the gradient)

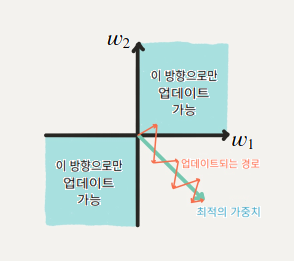

또한 시그모이드 함수의 출력은 0이 중심(zero-centerd)가 아니다. 그래서 훈련의 시간이 오래걸리게 된다.

Softmax

Softmax는 클래스의 수에 제한 없이 각 클래스의 확률을 구할 때 쓰인다. 예로, 가위 바위 보 사진 분류 문제는 3개 클래스 분류 문제이고, softmax는 각 클래스의 확률값 (0.2, 0.5, 0.3) 이런 식으로 출력값을 준다. softmax의 가장 큰 특징은, 확률의 성질인 모든 경우의 수(모든 클래스)의 확률을 더하면 1이되는 성질을 갖고 있기 때문에, 모델의 마지막 layer에서 활용된다는 점이다.

하이퍼볼릭 탄젠트

하이퍼볼릭 탄젠트 함수의 치역은 (-1, 1) 즉, -1 < σ(x) < 1 이다. 또한 0을 중심으로 하고 있기 때문에 시그모이드를 사용한 모델보다 더 빨리 훈련된다. 그러나 -1과 1에서 포화된다는 단점이 있다.

ReLU

f(x) = max(0, x)

ReLU함수의 치역은 (0, ∞)이다. 또한 하이퍼볼릭 탄젠트를 사용한 모델보다 몇 배 더 빠르게 훈련된다.

단점)

출력값이 0이 중심이 아니어서 실행이 느리다는 단점이 있다.

또한 Dying ReLU가 된다. 모델에서 ReLU를 사용한 노드가 비활성화되며 출력을 0으로만 하게 되는 것이다.

Leaky ReLU

Dying ReLU를 발생시켰던 0을 출력하던 부분을 아주 작은 음수값을 출력하게 만들어줘 해당 문제를 해결하였다. 이 부분을 제외하고는 ReLU와 같은 특성을 가진다.

PReLU(parametric ReLU)

Leaky ReLU와 유사하지만 새로운 파라미터를 추가하여 0 미만일 때의 기울기가 훈련되게 하였다.

ELU(exponential linear unit)

ReLU의 장점을 포함하며, 0이 중심점이 아니었던 단점과 Dying ReLU 문제를 해결한 활성화 함수이다. 그러나 exponential 계산이 들어가면서 계산 비용이 높아졌다는 단점이 있다.

https://www.youtube.com/watch?v=1Du1XScHCww

'AIFFEL' 카테고리의 다른 글

| AIFFEL 아이펠 34일차 (0) | 2022.02.17 |

|---|---|

| AIFFEL 아이펠 33일차 (0) | 2022.02.17 |

| AIFFEL 아이펠 31일차 (0) | 2022.02.16 |

| AIFFEL 아이펠 30일차 (0) | 2022.02.11 |

| AIFFEL 아이펠 29일차 (0) | 2022.02.10 |